Google a une énorme opération d'apprentissage automatique, il n'est donc pas surprenant que l'entreprise l'applique à chaque élément de données que nous alimentons, mais il y a quelque chose à propos de gâcher nos photos qui semble transgressif, quel que soit le sourire que Google essaie. mettez-le. Il y avait beaucoup de choses dans le discours d'ouverture de Google I / O 2021 qui ont frappé une note étrange, comme célébrer ses "principes de l'IA" après avoir traité son éthicien de longue date, le Dr Timnit Gebru, incitant l'entreprise à diriger ses scientifiques. "Soyez plus positif" à propos de l'IA. Mais c'est la partie du discours d'ouverture de Shimrit Ben-Yair, directeur de Google Photos, qui a été particulièrement bouleversante. Au cours de sa présentation, il a montré comment la technologie d'apprentissage automatique de Google était capable d'analyser toutes vos photos, d'identifier les similitudes moins reconnues dans l'ensemble de votre collection de photos et de regrouper vos photos en conséquence.

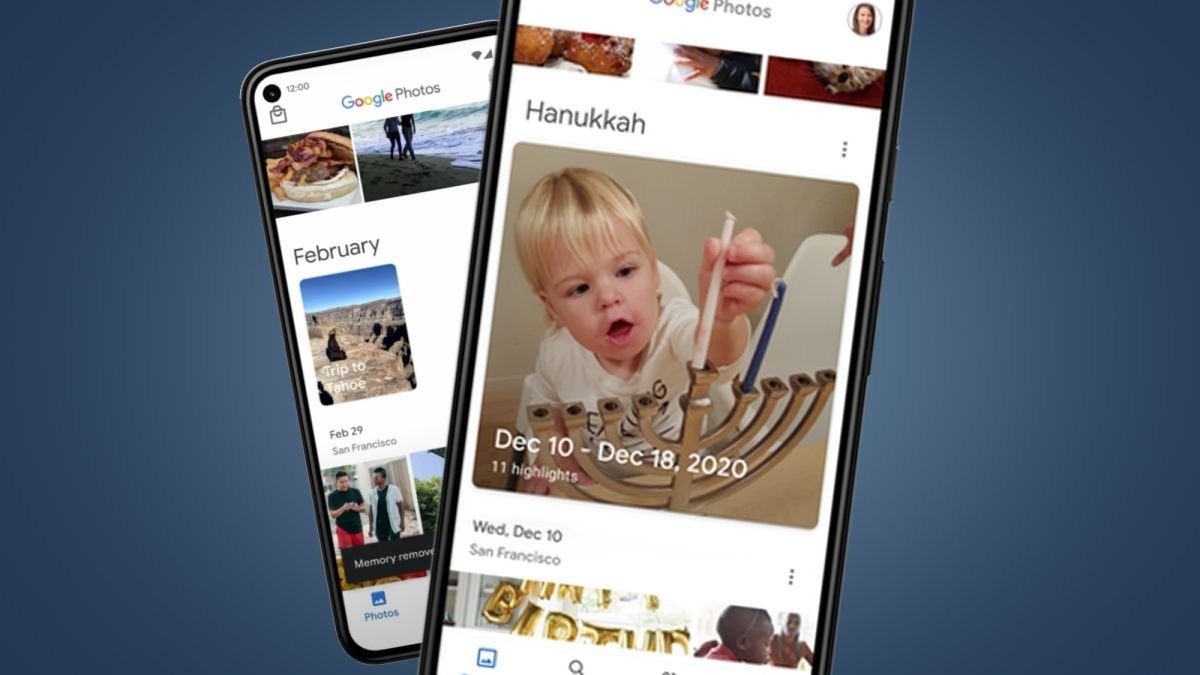

(Crédit image : Google) Autrement dit, Google exécute chaque photo que vous lui fournissez via des algorithmes d'apprentissage automatique très spécifiques et identifie des détails très spécifiques de votre vie, comme le fait que vous aimez parcourir le monde avec un de mes sacs, un arrière orange spécifique, par exemple. Heureusement, Google reconnaît au moins que cela pourrait être problématique si, par exemple, vous êtes transgenre et que l'algorithme de Google décide qu'il veut créer une collection de photos de pré-transition. Google comprend que cela peut être pénible pour vous, vous avez donc la possibilité complète de supprimer la photo incriminée des collections à l'avenir. Vous pouvez également leur demander de supprimer toutes les photos prises à une date précise qui pourraient être douloureuses, comme le jour où un être cher est décédé. Tout cela vaut mieux que de ne pas avoir cette option du tout, mais la responsabilité incombe toujours à vous, l'utilisateur, qui l'est toujours, l'est toujours. Qu'est-ce qui est un peu pénible pour certains lorsque Google a de nouvelles fonctionnalités à mettre en œuvre que personne ne demandait ? Ensuite, nous arrivons à la partie de la présentation où Google prendrait une sélection de deux ou trois photos prises ensemble, comme lorsque vous prenez beaucoup de photos à la suite pour en capturer une où personne ne clignote sur une photo de groupe, et appliquez son apprentissage automatique pour générer un petit "plan cinématographique" avec eux. Cette fonctionnalité, introduite pour la première fois en décembre 2020, utilisera l'apprentissage automatique pour insérer des cadres entièrement fabriqués entre ces photos afin de générer essentiellement un GIF, recréant un événement en direct d'une manière qui est un fac-similé de l'événement tel qu'il s'est produit. Accent mis sur l'envoi de fax.

(Crédit image : Google) Google présente cela comme une aide pour se souvenir de vieilles photos, mais ce n'est pas ce que c'est, c'est le début de la fin de la réminiscence telle que nous la connaissons. Pourquoi faire confiance à votre mémoire alors que Google ne peut en générer qu'une pour vous ? Peu importe si vous créez un enregistrement de quelque chose qui ne s'est pas vraiment produit et que vous le présentez comme si cela s'était produit. Bien sûr, vos yeux auraient pu clignoter "quelque chose comme ça" entre ces deux photos et ce n'est pas comme si Google vous forçait à faire des lignes de coke lors d'une fête alors que vous n'en faisiez pas une, telle ou telle. Mais lorsqu'il s'agit de ce qui est éthique et de ce qui ne l'est pas, il n'y a pas de place pour le « genre ». Ce sont le genre de choix qui nous conduisent sur des chemins que nous ne voulons pas emprunter, et chaque pas sur un chemin rend plus difficile pour nous de revenir en arrière. S'il y a une chose que nous aurions vraiment dû apprendre au cours de la dernière décennie, c'est de ne pas avoir une confiance aussi aveugle dans les algorithmes d'apprentissage automatique qui ont le pouvoir de déformer notre perception de la réalité scientifique. QAnon est autant un produit d'apprentissage automatique que Netflix, mais maintenant nous allons mettre nos albums photo sur l'autel de l'IA et appeler tout ce qui se présente "Memories". Pendant ce temps, beaucoup d'énergie réelle est dépensée pour exécuter tous ces algorithmes dans des centres de données à mesure que le changement climatique progresse. À chaque nouvelle avancée de la plate-forme d'apprentissage automatique de Google, il devient de plus en plus évident que vous devriez vraiment écouter ce que des éthiciens comme le Dr Gebru essaient de vous dire, et il devient encore plus évident que vous n'avez aucun intérêt à le faire.